AI白嫖方案-新

经验创意

·

2857 次浏览

H-D-G

创建于 2024-09-01 12:34

之前做了个白嫖AI服务的动作(利用了@抄书侠大佬提供的逆向中转服务),但逆向项目不稳定,现在很多服务已经无法使用。以后有什么白嫖的方案我会分享到这里。

讯飞星火(2024年9月01日)

星火开放了无限token的Spark Lite模型,以下是获取方法:

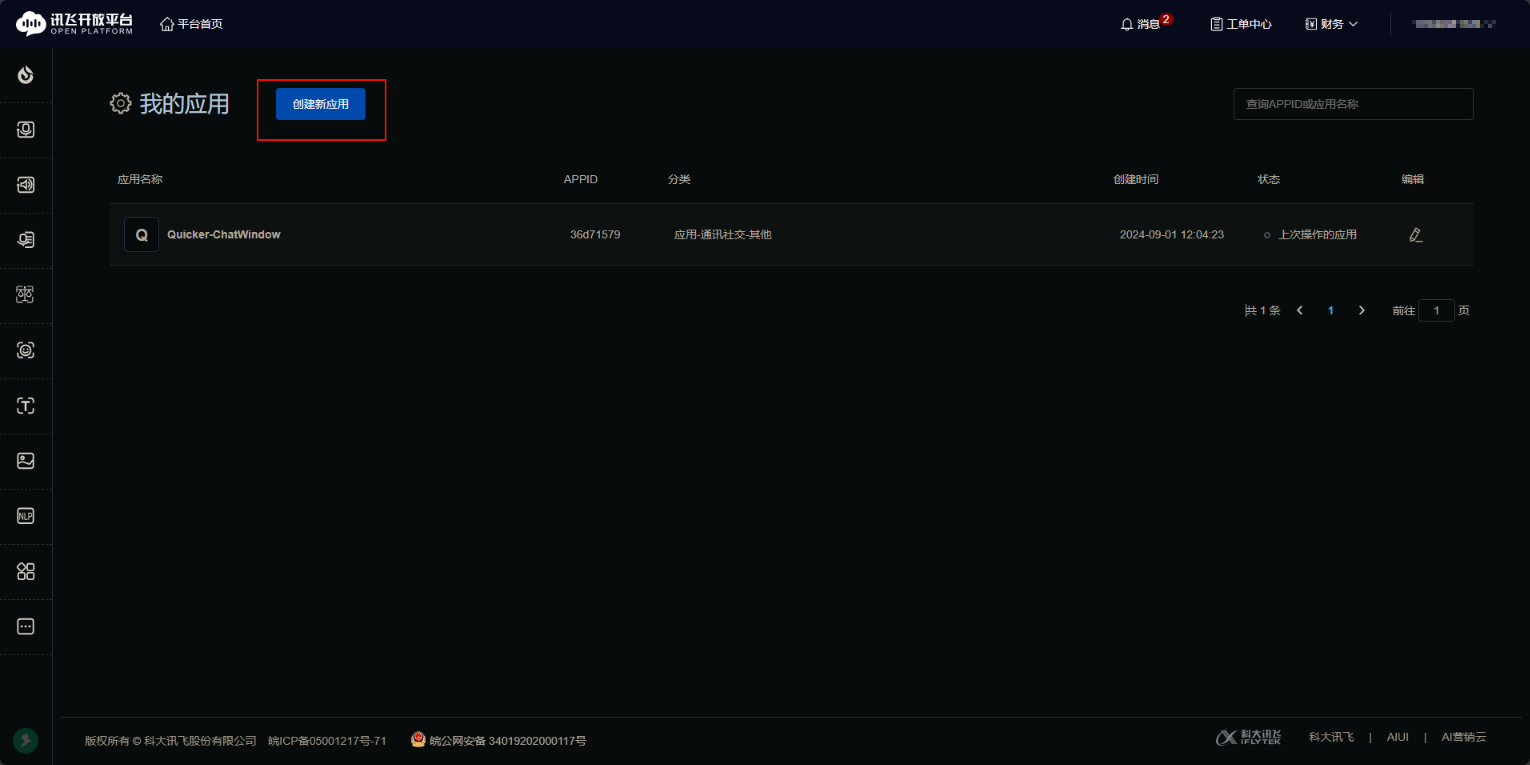

- https://console.xfyun.cn/services/bm2 注册一个账号并创建一个应用:

应用名称和分类随意,随便填都可以

应用名称和分类随意,随便填都可以 - 创建后一般会直接跳转到应用的设置界面(没有跳转就手动点击一下应用)

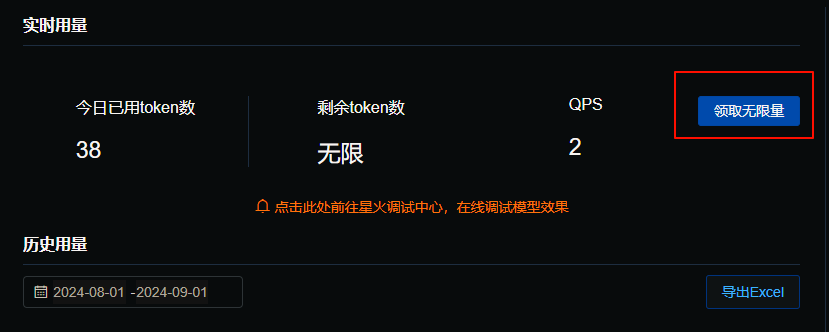

点击这个选项,会弹出一个提示要求你实名认证,认证后等待审核(审核很快,我当时只花了10分钟不到)

点击这个选项,会弹出一个提示要求你实名认证,认证后等待审核(审核很快,我当时只花了10分钟不到)  然后点击这个选项,领取无限量token即可

然后点击这个选项,领取无限量token即可 领取后复制【APIPassword】

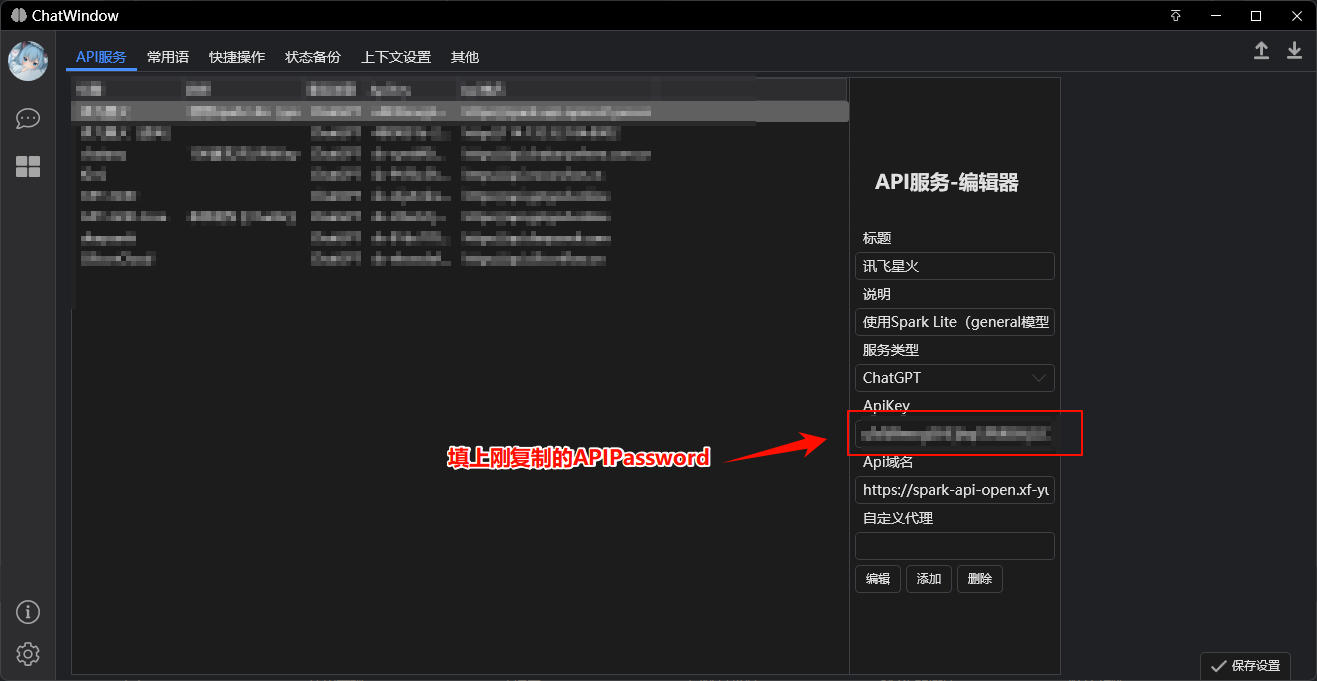

领取后复制【APIPassword】- 然后回到ChatWindow,添加一个新的服务:

API域名是:https://spark-api-open.xf-yun.com/

H-D-G

最后更新于 2024/9/1

回复

请绑定手机号后发表评论

京公网安备 11010502053266号

京公网安备 11010502053266号